情報理論¶

- エントロピー entropy

- 最大エントロピー

- 条件付きエントロピー

- カルバック=ライブラーダイバージェンス

- 相互情報量

情報量 Information Measure¶

- 情報量: 確率変数 のサプライズ量

- まれにしか起こらない事象が起こった場合には情報量は大きい。ニュースになる

- 必ず起こることが起こっても情報量は小さい。ニュースにならない

- マイナスをつけるのは正の値にするため

熱力学と情報理論¶

ボルツマン(左)とシャノン(右) 出典:ウィキペディア

- エントロピー: 確率変数の平均情報量

- 物理学起源

- 熱力学の平衡の概念

- 統計力学

ボルツマン Ludwig Eduard Boltzmann (1844-1906)¶

- 統計力学

- 第一法則: エネルギー保存

- 第二法則: エントロピー増大

- マクロとミクロをつなぐ

エントロピー¶

乱雑さの度合い。出典:

物理学におけるエントロピー ¶

- 個の物質が 個の状態,各状態には 個の物質

- 個の物質を全て並べる:

- 各状態の中では物質の順序は問わないことにする

- 総数 個の物質を に分ける場合の組み合わせ:

-

エントロピーの定義

-

スターリングの公式 を用いて

- 全体の分布 をマクロステート

- 各 のミクロの状態 を

連続系のエントロピー ¶

- 離散量 を考えて を考える:

- 連続系のエントロピー

- の極限を考えれば:

- 連続系と離散系のエントロピーは だけ異なる

連続系のエントロピーを最大化する分布¶

- どのような分布が連続系のエントロピーを最大化するか?

- 離散系では一様分布

- 連続系では?

汎関数としてのエントロピー ¶

- 通常の関数: 微分 := スカラを入力として,スカラを返す関数(演算子)

- 汎関数: 関数を入力としてスカラを返す関数(演算子)

- 機械学習における汎関数の例: スカラ値を返すエントロピー を最大化

- 変分原理あるいは変分推論

Maximizing a Functional¶

- 汎関数: 関数からスカラへの写像

- 最大値を与える関数を探す

- 制約付の最大化(最小化)

- ラグランジアン Lagrangeanの利用

エントロピーの最大化¶

- 確率の制約,及び,平均と分散に関する制約条件を以下のように記述:

- : 確率

- : 平均

- : 分散

- ラグランジェ乗数を使って制約条件下での最大化<

各変数で微分して0と置き,整理:

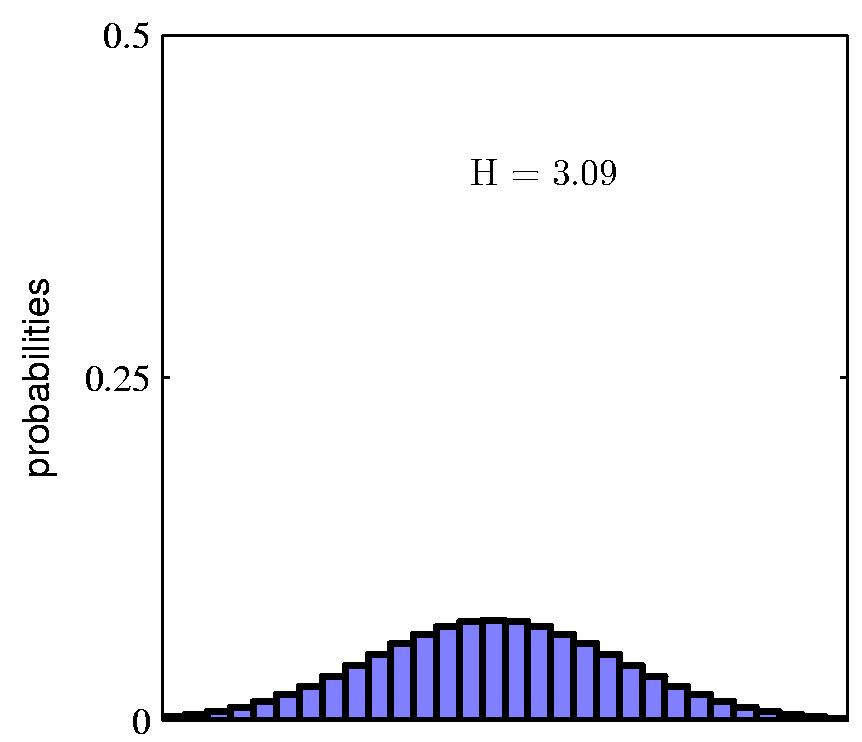

- 以上より連続量の最大エントロピーを与える確率分布はガウス分布となる

正規分布のエントロピーの微分¶

- このとき最大エントロピーは以下:

- 分散が大きくなればエントロピーは増大する

- 離散系のエントロピーとは異なり,連続系のエントロピーは のとき,負となる

条件付きエントロピー Conditional Entropy¶

- 同時確率 に対して

-

が所与のとき条件付きエントロピー

-

さらに以下の関係がある

相対エントロピー ¶

- 未知の分布(真に知らんと欲する分布) を,(例えばニュールネットワークなどにより) で近似することを考える。

- 相対エントロピー(KLダイバージェンス)を用いて真の分布 の代わりに を用いた結果 の値を特定するために必要な平均情報量

- ベイズ推論:

- エントロピー: 情報論から

- KL ダイバージェンス(相対情報量): パターン認識から

相対エントロピーと KL ダイバージェンス ¶

- 相対エントロピーの式に を代入

- KL ダイバージェンスは非対称性:

- K-L ダイバージェンスは常に正か 。 等号が成り立つのは のときのみ

相互情報量 Mutual Information¶

- 2 変量 , が与えら得た時同時確率 について:

- 両変量が独立な場合:

- 独立でないければ:

- 同時確率との KL ダイバージェンス